12月8日,智谱AI发布并开源 GLM-4.6V 系列多模态大模型,沐曦股份曦云C系列GPU完成Day 0适配。

GLM-4.6V 系列多模态大模型共包含两款模型:

GLM-4.6V(106B-A12B):面向云端与高性能集群场景的基础版;

GLM-4.6V-Flash(9B):面向本地部署与低延迟应用的轻量版。

作为 GLM 系列在多模态方向上的一次重要迭代,GLM-4.6V 将训练时上下文窗口提升到 128k tokens,在视觉理解精度上达到同参数规模 SOTA,并首次在模型架构中将 Function Call(工具调用)能力原生融入视觉模型,打通从「视觉感知」到「可执行行动(Action)」的链路,为真实业务场景中的多模态 Agent 提供统一的技术底座。

一、原生多模态工具调用

传统工具调用大多基于纯文本,在面对图像、视频、复杂文档等多模态内容时,需要多次中间转换,带来信息损失和工程复杂度。

GLM-4.6V 从设计之初就围绕 「图像即参数,结果即上下文」 ,构建了原生多模态工具调用能力:

输入多模态:图像、截图、文档页面等可以直接作为工具参数,无需先转为文字描述再解析,减少链路损耗。

输出多模态:对于工具返回的统计图表、渲染后网页截图、检索到的商品图片等结果,模型能够再次进行视觉理解,将其纳入后续推理链路。

模型原生支持基于视觉输入的工具调用,完整打通从感知到理解到执行的闭环。这使得 GLM-4.6V 能够应对图文混排输出、商品识别与好价推荐、以及辅助型 Agent 场景等更复杂的视觉任务。

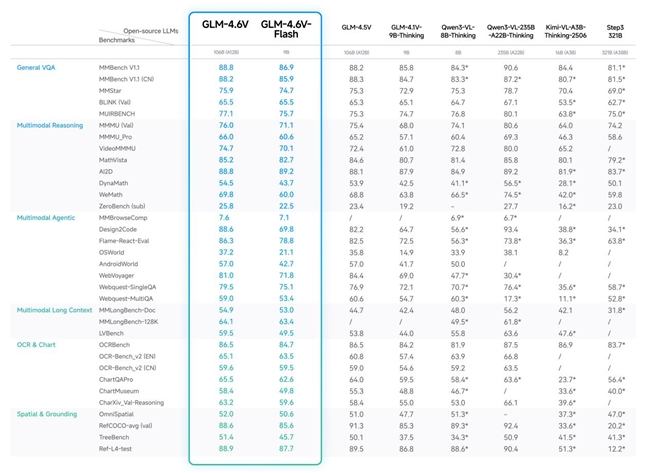

二、同规模开源 SOTA

GLM-4.6V 在 MMBench、MathVista、OCRBench 等 30+ 主流多模态评测基准 上进行了验证,较上一代模型取得显著提升。在同等参数规模下,模型在多模态交互、逻辑推理和长上下文等关键能力上取得 SOTA 表现。

三、MXMACA软件栈加速国产模型落地

MXMACA软件栈作为沐曦股份全栈GPU解决方案的核心,在vLLM,sglang 等主流AI推理框架中展现出快速适配的优势,其GPU架构和优化设计和良好的生态兼容性确保了高效、灵活的推理部署。此次沐曦股份曦云C系列GPU完成Day 0适配智谱GLM-4.6V 系列多模态大模型再次印证了这一优势。MXMACA软件栈将继续以开放式架构和持续迭代优化,赋能推理框架、模型、应用开发到运维的全生命周期,助力开发者构建更具竞争力的AI产品。

免责声明:市场有风险,选择需谨慎!此文仅供参考,不作买卖依据。